AI Hub と Kubeflow Pipelines を発表 ―― AI をよりシンプル、高速、便利なものに

Google Cloud Japan Team

※この投稿は米国時間 2018 年 11 月 8 日に Google Cloud blog に投稿されたものの抄訳です。

アパレル サプライチェーンに革命を起こしたり、電子商取引を高速化したりといったように、あらゆる業種の企業がビジネスを進化させるために AI の利用を進めています。しかし、多くの企業にとって、AI の本格的な導入に伴う複雑さは非常に厄介なようです。

私たち Google の目標は、AI をすべての企業にとって手の届くものにすることです。しかし、そのためには参入の敷居を下げなければなりません。そこで私たちは、3 つのことを念頭に置いてすべての AI サービスを構築しています。それは、「より多くの企業が導入できるようにシンプルにすること」「できるだけ多様な組織にとって便利なものにすること」「企業がより迅速に導入でき、繰り返し利用して成功を収められるように高速化すること」です。

Google は今年初め、機械学習(ML)に関する知識やノウハウが限られた企業でもカスタム ML モデルを構築できるよう支援するために、Cloud AutoML を発表しました。また、機械学習に関するスキルセットの幅広い習得の促進に特化したトレーニングや認定資格プログラムに加え、お客様が Google の機械学習エンジニアとオンサイトで協力しながらトレーニングや開発を行うための Advanced Solutions Lab(ASL)等、様々な形でリソースを提供しています。こうした取り組みはいずれも企業における AI の導入拡大に貢献しており、これまでに様々な業界から、 15,000 以上のお客様(有償利用)に AI サービスをご利用いただいております。

私たちは、AI をより高速、シンプルで、便利なものにするためのもう 1 つの方法として、データ サイエンティストが効果的に仕事をこなせるように支援も行っています。デベロッパーは全世界で 2,000 万人程度いますが、データ サイエンティストは 200 万人しかいません。彼らは自身の取り組みを大規模に展開できるツールを必要としており、企業はそうした仕事の成果を利用したり、デベロッパーやエンジニアにとってアクセスしやすくしたりするための方法を必要としています。本日、Google では、そのような声に応える新しい製品を私たちの AI 製品のポートフォリオに追加しました。

AI Hub で AI がよりシンプルに

AI を企業にとって手の届くものにするためには、既存のツールや成果を容易に発見、共有、再利用できるようにする必要があります。本日提供を開始する AI Hub は、企業による包括的なリソースの整備をサポートします。AI Hub は、各種のプラグ・アンド・プレイ型 機械学習コンテンツ(パイプライン、Jupyter Notebook、TensorFlow モジュールなど)を 1 か所で入手、配布できる場です。AI Hub には 2 つの大きなメリットがあります。1 つは、すべての企業が Google Cloud AI や Google Research、Google 社内のチームが開発した高品質な機械学習リソースに自由にアクセスできること。そしてもう 1 つのメリットは、企業が機械学習リソースをアップロードして、社内だけで共有できるプライベートで安全なハブとして機能します。AI Hub により、企業はほんの数ステップで、GCP(もしくは Kubeflow Pipelines システムを使用したハイブリッド インフラストラクチャ)でパイプラインを再利用し、本番環境にデプロイすることができます。

AI Hub のアルファ版は、Google が開発したリソースや、プライベートな共有機能を提供します。一方、ベータ版はさまざまな資産タイプをカバーし、パートナーのソリューションを含む幅広いパブリック コンテンツを提供します。

Kubeflow Pipelines と最新の Video API で AI がより便利に

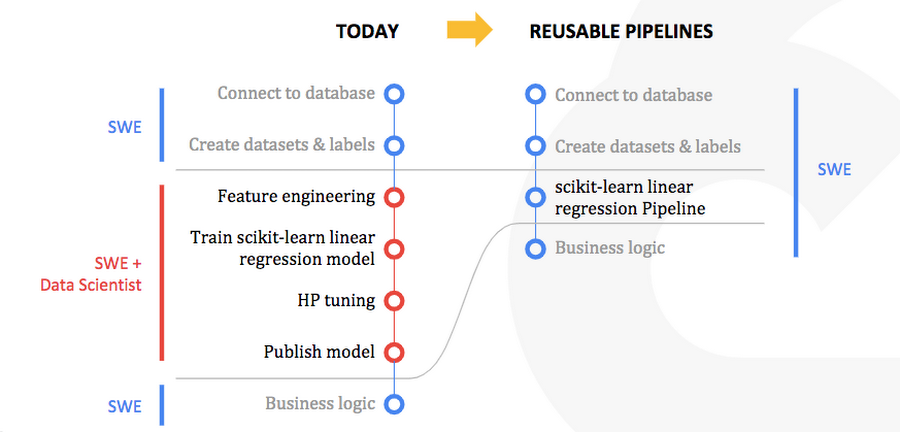

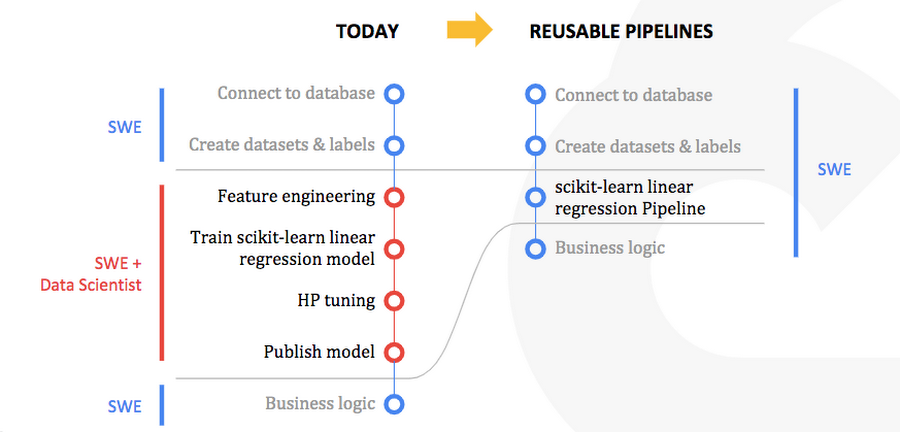

AI 活用を目指す企業をより強力にサポートするために、機械学習リソースを構築し、パッケージ化する方法として、本日 Kubeflow Pipelines の提供も開始しました。Kubeflow Pipelines は、Google が立ち上げたオープンソース プロジェクトである Kubeflow の新しいコンポーネントで、アプリケーションを構築するのと同様に機械学習コードをパッケージ化し、社内の他のユーザーが再利用できるようにします。再利用可能なエンドツーエンドの機械学習ワークフローを作成、デプロイ、管理できるワークベンチを提供し、これによって、プロトタイピングから本番稼働まで対応できる、ロックインの心配がないハイブリッド ソリューションとなっています。また、迅速で信頼性の高い実験が可能なため、ユーザー自身がさまざまな機械学習技術を試し、どれがアプリケーションに最適かを判断することができます。

公平性は私たちの「AI 利用における基本理念」の 1 つであり、機械学習をビジネスに導入するお客様と話し合うテーマでもあります。Kubeflow Pipelines は Google の TensorFlow Extended(TFX)をお客様が利用できるように支援します。TFX は、ML の本番利用に伴う問題、たとえばモデル分析、データ検証、トレーニングとサービスのずれ、データ ドリフトなどに対応するためのオープンソース ライブラリです。企業は TFX を用いて結果の精度、関連性、公平性を高めることができます。Kubeflow Pipelines は GitHub でご利用いただけます。

また、私たちは 、企業にとってより便利なものにするために、AI を構築するためのパーツ (AI Building Block) の機能拡張も継続して進めています。たとえば、Cloud Video Intelligence API の 3 つの機能をベータ リリースし、動画を広範に扱う企業が抱る一般的な問題に対応できるようにしています。

Text Detection は、50 以上の言語に対応している他、動画内でテキストがいつどこで現れるかを特定し、動画内のテキスト検索の迅速化を可能にしています。Object Tracking 機能は動画内のオブジェクトの 500 以上のクラスを識別できます。Speech Transcription は音声の文字起こしを可能にする機能で、キャプションやサブタイトルの簡単な作成や、テキスト コンテンツの検索性を高めることができます。AI Building Block についてもっと知りたい方は、こちらをご覧ください。

Cloud TPU をアップデート、 AI がより高速に

Google は Cloud Tensor Processing Unit(TPU)を使用して AI のコンピューティング上の障害を継続的に軽減しています。Google の設計によるこの ML ワークロード向けカスタム ASIC チップは、ML タスクを劇的に高速化し、クラウドを介して簡単にアクセス可能です。今年 7 月には第 2 世代 TPU の一般提供を開始し、無料枠ユーザーを含むすべての GCP ユーザーにご利用いただけるようになりました。10 月には第 3 世代の水冷式 Cloud TPU のベータ版を発表するとともに、PyTorch を Google Cloud 全体で利用できるようにしています。PyTorch は近いうちに TPU 上で利用可能になる予定です。さらに本日、TPU V2 Pods の料金も発表しました。これらのアップデートはすべて、コンピュート集約型の ML を高速化し、世界中の企業にとって利用しやすくすることを目指したものです。TPU の詳細はこちらをご覧ください。

今後に向けて

ここ数か月にわたり、ユニークなビジネス課題を AI で解決することに成功したという報告が、多くのお客様から寄せられています。メディア企業の Meredith Corporation は、Cloud AutoML と Cloud Natural Language を使ってカスタムの汎用分類器を開発し、コンテンツ分類を自動化しています。コンテンツ分類の再現性とスケーラビリティを高めるために機械学習を活用し、時間を節約するとともに読者のオンライン体験の向上に活用しています。

Meredith Corporation の Chief Marketing & Data Officer である Alysia Borsa 氏は、「当社はさまざまなプラットフォームやライフ ステージにわたって、PEOPLE、Better Homes & Gardens、Martha Stewart Living、Allrecipes、Food & Wine といったブランド毎に魅力的なコンテンツ制作に取り組んでいます」と前置きしたうえで、次のように述べています。「Natural Language と Cloud AutoML サービスを使ってカスタムの汎用分類器をコンテンツに適用することで、新しいトレンドの発見と対応を的確に行い、強力かつきめ細かなターゲティングを実現し、有意義で魅力的な体験を読者に提供しています。」

エモリー大学は、臨床データ、機械学習、GCP のスケーラブルなインフラストラクチャを組み合わせ、敗血症の発症を予測するエンジンを開発し、リアルタイムでデータを分析することで危険な状態の患者に適切な処置を行うとともに医療費の抑制を目指しています。

「敗血症は早期発見が重要です。私たちは、TensorFlow ベースの敗血症予測アルゴリズムをアプリケーションに変換し、Google App Engine で実行することで、医師が患者に対して適切な処置を行うことができるベストなタイミングでの情報提供を可能にしました。最も重要なことは、ICU 内の患者の治療結果を改善することです。機械学習は患者ケアを最適化するうえで不可欠です」(エモリー大学医学部生物医学情報学科 助教授 Ashish Sharma 博士)

Geotab は、BigQuery ML と BigQuery GIS を使用してシカゴ内の事故が起こりやすい危険なエリアを予測し、データに基づいた意思決定を後押しするとともに、スマート シティへの取組みを支援しています。

「当社はデータに基づいた業務用車両に関するインサイトを全大陸で提供しています」と、Geotab のデータ&アナリティクス担当バイス プレジデントを務める Mike Branch 氏は語り、その取組みを次のように説明しています。「当社では機械学習と BigQuery を活用することで、都市内の特に危険な運転エリアを、天候と交通フローに基づいて予測するソリューションを開発しました。Google Cloud が提供する機械学習技術の力を借りて、お客様とコミュニティのための優れたソリューションを生み出すお手伝いができることを、当社は大変喜ばしく思っています。」

加えて、私たちは、Kubeflow のコミュニティが成長を続けていることも、とてもうれしく思っています。Cisco や NVIDIA のような企業は、このオープンソース プロジェクトの主要なコントリビューターであり、私たちはこれらの企業と密接に協力し、Kubeflow Pipelines の導入を進めています。NVIDIA はすでに、オープンソースの新しいデータ サイエンス ライブラリ スイートである RAPIDS を Kubeflow に統合しつつあります。RAPIDS ライブラリは GPU を活用してデータの前処理や機械学習を劇的にスピードアップするなど、Kubeflow に対する補完性に優れています。

「機械学習は弊社の顧客の皆様が取り組んでいるデジタル変革に不可欠な要素として、急速にその存在感を増しつつあります。さらに、データ サイエンティストにも適応できるアーキテクチャをデプロイしようとしている企業の IT 部門やメインストリームのエンジニアチームにおいても、機械学習は注目をますます集めています。しかし企業で機械学習を最大限に活用するには、ソリューション全体のライフサイクルを大幅に簡素化する必要があります」 Cisco のコンピューティング システム製品グループのストレージ担当ストラテジー & プロダクト開発バイス プレジデントである Kaustubh Das 氏はこのように述べています。「 Cisco は Kubeflow の主要コントリビューターとして、ハイブリッドまたはマルチクラウドの AI や機械学習のライフサイクル管理の簡素化を目指しています。また、ワークフローを抜本的に簡素化する Kubeflow Pipeline の登場についても嬉しく思っています。このワークフローの簡素化は、機械学習の一般利用に欠かすことができないものです。私たちは、これらの最新ソリューションを役立て、世界水準の AI / 機械学習の関連製品ポートフォリオとともに、お客様にご提供してまいります」

Google はこれからもお客様やパートナーと密接に連携し、ビジネス課題と AI がどのようにそれらの課題を解決できるかについて追求していきます。Google Cloud における AI や機械学習についての詳細はこちらをご覧ください。

- By Rajen Sheth, Director of Product Management, Cloud AI