Cloud Machine Learning API を使った会話アプリの作成 - Part 2

Google Cloud Japan Team

このブログ記事の Part 1 では、Cloud Machine Learning API と API.AI を使って構築される iOS 対応の会話型ツアー ガイド アプリがどのようなものかを紹介しました。また、API.AI のインテントとコンテキストの作成方法も説明しました。

Part 2 では、API.AI の高度なトピックであるウェブフックと Cloud Functions を取り上げます。Cloud Machine Learning API(Speech、Vision、Translation の各 API)の使い方や、2 つ目の言語のサポート方法も解説します。

Cloud Functions によるウェブフック

API.AI ではウェブフックの統合を利用して、マッチされたインテントからウェブ サービスに情報を渡し、結果を取得できます。パレードの情報をリクエストし、Cloud Functions から入手する方法を見ていきましょう。

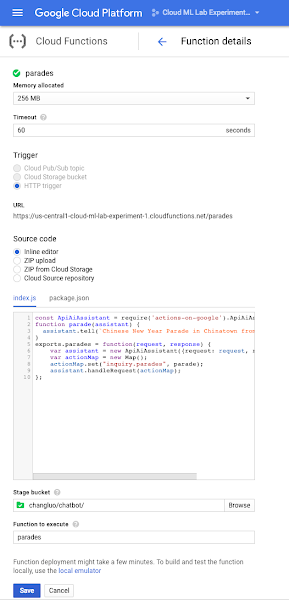

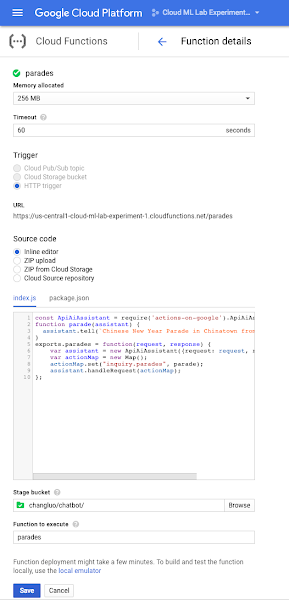

4. 関数を作成します。ここでは “parades”(パレード)という名前の関数を作成することにします。“HTTP trigger”(HTTP トリガ)オプションを選択し、“Inline editor”(インライン エディタ)を選択します。

5. 実行する関数を “parades” と指定することを忘れないでください。

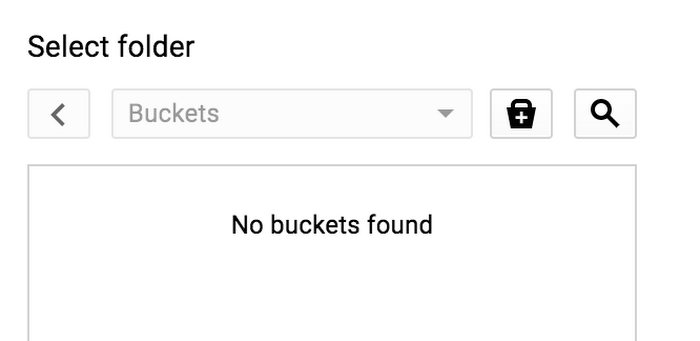

“ステージ バケット” も作成する必要があります。“browse”(ブラウズ)をクリックするとブラウザが表示されますが、バケットはまだありません。

6. “+” ボタンをクリックし、バケットを作成します。

- バケットの一意な名前を指定し(たとえばプロジェクト名が使えます)、“regional”(リージョナル)ストレージを選択し、デフォルトのリージョンのままにします(us-central1)。

- 前のウィンドウで “select”(選択)ボタンをクリックします。

- “Create”(作成)ボタンをクリックし、関数を作成します。

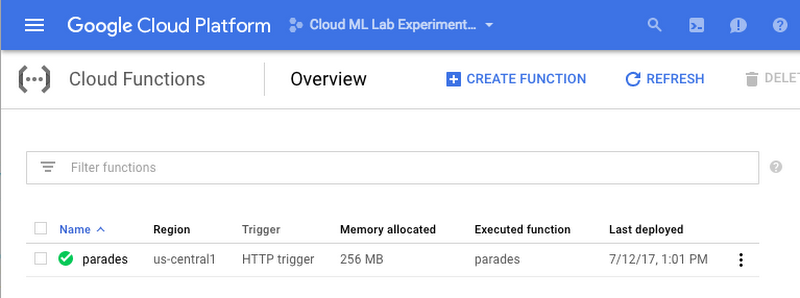

関数が作成され、デプロイされます。

7. “parades” 関数行をクリックします。“source”(ソース)タブでソースを見ることができます。

いよいよ私たちの関数のコーディングです! 2 つのファイルが必要になります。“index.js” ファイルには JavaScript / Node.JS のロジックが含まれます。“package.json” ファイルには、私たちの関数で必要な依存関係など、Node パッケージの定義が含まれます。

package.json ファイルは以下のとおりです。これで、NPM モジュールの actions-on-google を利用して、API.AI および Actions on Google プラットフォームとの統合を容易に行うことができます。この統合により、皆さんのエクステンション(Google Home から使えます)で Google アシスタントを拡張することが可能になります。

index.js ファイルのコードは以下のとおりです。

上のコードの内容を説明します。

- NPM モジュールの actions-on-google を要求します。

- ask() メソッドを使って、アシスタントからユーザーに結果を送信させます。

- 関数をエクスポートします。この関数では、actions-on-google モジュールの ApiAiApp クラスを使ってリクエストを処理します。

- API.AI から JavaScript 関数に “intents” をマップするためのマップを作成します。

- handleRequest() を呼び出してリクエストを処理します。

- コードを入力したら、必ず関数の “create” ボタンをクリックします。これで関数がクラウドにデプロイされます。

tell() APIと ask() API には微妙な違いがあります。tell() は会話を終了させ、マイクを閉じますが、ask() はそうではありません。この違いは、このブログ記事の Part 1 と Part 2 で説明しているような API.AI プロジェクトでは重要ではありません。Part 3 で Actions on Google を統合する際に、この違いについて詳しく説明します。

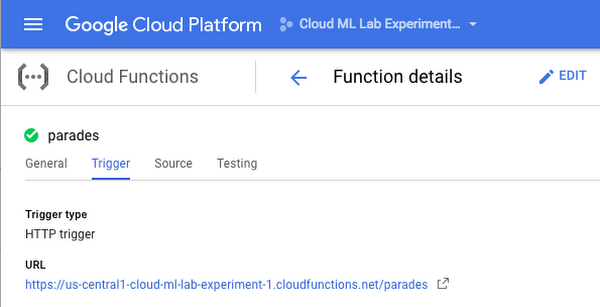

下の画面の “Testing”(テスト)タブは関数を呼び出し、“General”(一般)タブは統計情報を表示し、“Trigger”(トリガ)タブは関数のために作成された HTTP URL を示します。

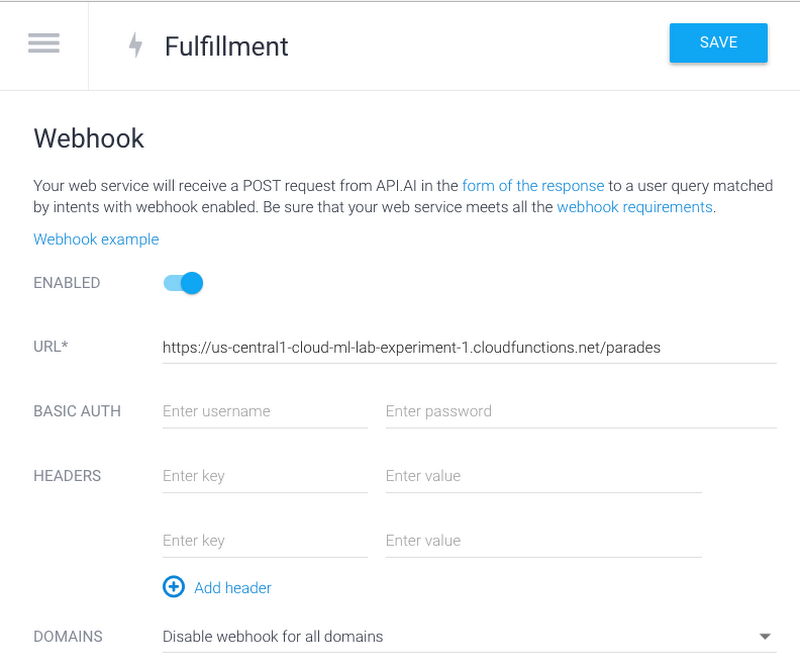

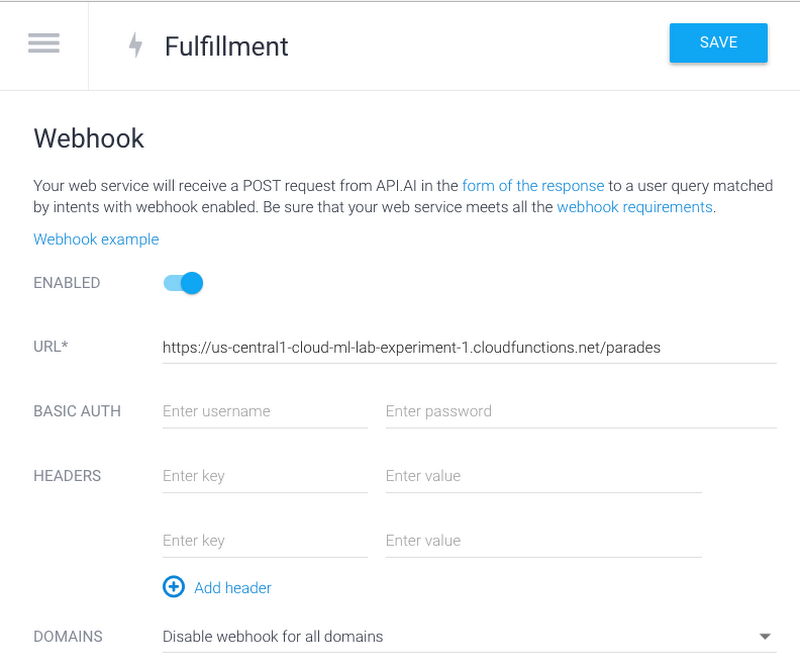

最後に、API.AI コンソールに移動し、“Fulfillment” タブをクリックします。ウェブフックを有効にし、上の URL を URL フィールドに貼り付けます。

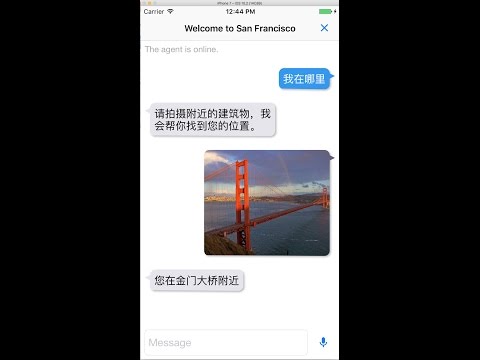

以上で、テキストを介して人と会話するチャットボットを API.AI で作成することができました。次に、Cloud Speech API でボットが「聞く」ことを、Cloud Vision API で「見る」ことを、iOS のテキスト音声変換 SDK で「話す」ことを、Cloud Translation API で「翻訳する」ことを可能にしましょう。

Cloud Speech API の使用

Cloud Speech API にはサンプル iOS アプリが含まれています。gRPC 対応の非ストリーミング サンプル アプリを私たちのチャットボット アプリに統合することは、至って簡単です。Google Cloud Console から API キーを入手し、SpeechRecognitionService.m の次の行でその API キーを指定します。

ランドマーク検出

iOS で Cloud Vision API を使用するときは、この例に従ってください。上のように、ラベルと顔の検出をランドマーク検出に置き換える必要があります。

Cloud Speech API で使用したのと同じ API キーが使えます。

テキスト音声変換

iOS 7 以降では、テキスト音声変換 SDK である AVSpeechSynthesizer がビルトインで用意されています。以下のコードだけで、テキストを音声に変換できます。複数言語のサポート

Cloud Speech API で新たな言語をサポートするには、iOS クライアント側で 1 行を変更します(現在、複数言語を同時に使うことはできません)。中国語をサポートするには、SpeechRecognitionService.m のこの行を置き換えます。

上の行を以下のように変更します。

テキスト音声変換で中国語をサポートするには、コードに次の行を追加します。

Cloud Speech API と Apple の AVSpeechSynthesisVoice は、BCP-47 言語コードをサポートしています。

Cloud Vision API のランドマーク検出機能は現在、英語しかサポートしていません。そのため、他の言語で検出する場合は、英語のランドマーク記述を受け取った後で、Cloud Translation API を使って目的の言語に翻訳する必要があります(Translation API は、Cloud Vision API や Cloud Speech API のように使います)。

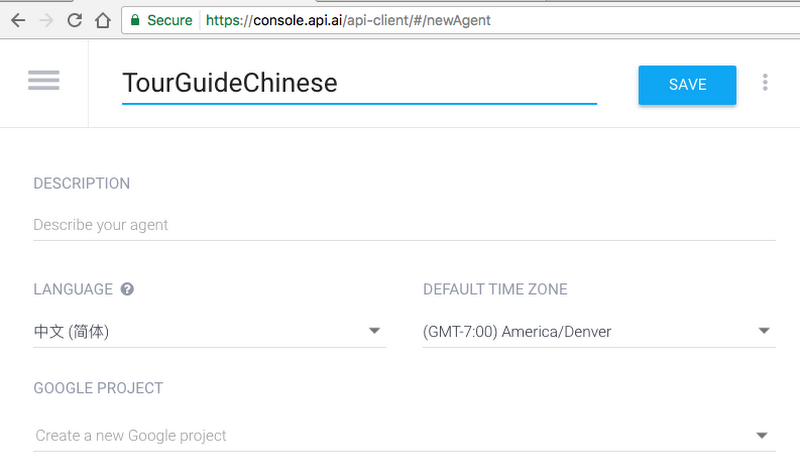

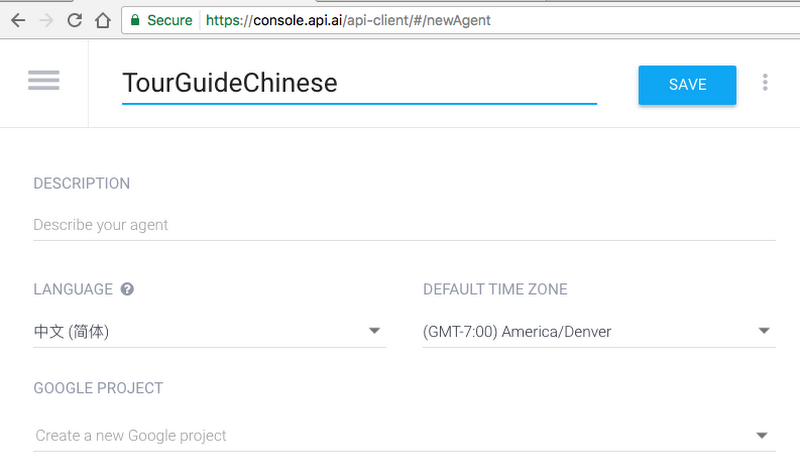

API.AI 側では、新しいエージェントを作成し、その言語を中国語に設定する必要があります。1 つのエージェントは 1 つの言語しかサポートできないからです。同じエージェントを 2 つ目の言語で使おうとすると、その言語については機械学習が機能しません。

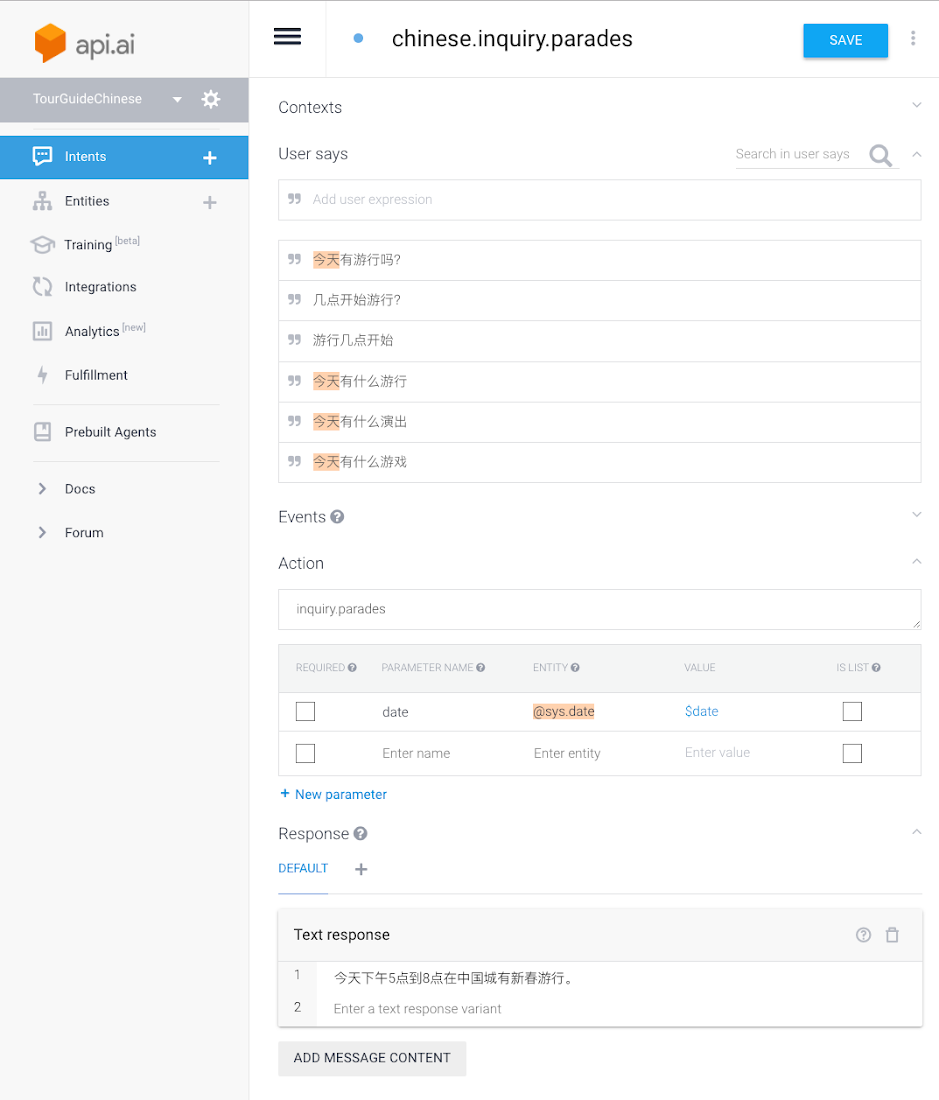

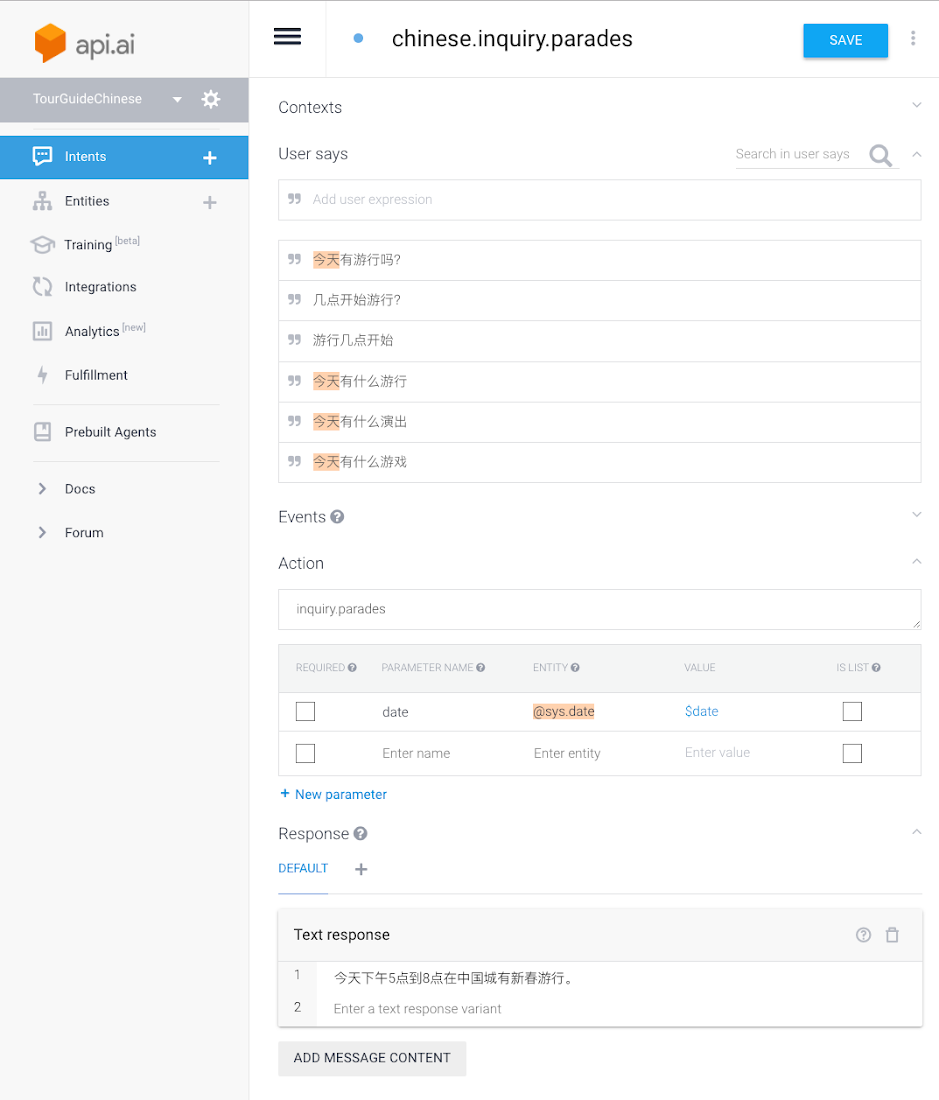

また、すべてのインテントとエンティティを中国語で作成する必要もあります。

これで完了です。英語と中国語をサポートするシンプルな “ツアー ガイド” チャットボットを作成できました。

次回の予定

このサンプル アプリを通じて、機械学習を利用したアプリの作成が簡単なことをおわかりいただけたと思います。さらに多くの情報を得たいのであれば、以下のクイックスタートを試してみるとよいでしょう。- Cloud Speech API Quickstart

- Cloud Vision API Quickstart

- Cloud Translation API Quickstart

- API.AI Quickstart

ソース コードは GitHub からダウンロードできます。

Part 3 では、Google アシスタント をベースに Actions on Google との統合を利用して、このアプリを作成する方法を紹介します。

* この投稿は米国時間 8 月 16 日、Software Engineer である Chang Luo と Bob Liu によって投稿されたもの(投稿はこちら)の抄訳です。

- By Chang Luo and Bob Liu, Software Engineers